Si ya es difícil la aceptación de un espacio tetradimensional, o sea, las tres dimensiones del entorno en que nos movemos, más el tiempo, cuando se habla de la existencia de diez o más dimensiones, aparece una notable incredulidad. Pero la teoría de las supercuerdas necesita diez dimensiones, y más, para describir nuestro universo. La razón no es simple, pero es así. Cuando se teoriza la existencia de seis dimensiones adicionales, el físico teórico está pensando en una diminuta cuerda que se encuentra compactada y enrollada dentro de un pequeñísimo espacio de 10-33 cm, lo que, por su tamaño, hace muy difícil poder detectar las dimensiones de dicha cuerda. Pero fundamentos en la naturaleza, como para pensar que puede darse esa condición, existen.

La idea de las dimensiones extras para un universo considerado tetradimensional, no es nueva, sino que se extrae de la teoría de Theodoro Kaluza y de Oskar Klein. Este mecanismo es reconocido por los físicos como teoría o compactificación de Kaluza-Klein. Kaluza, que, en su trabajo original, demostraba que comenzando desde la relatividad general con un espaciotiempo pentadimensional, al situarse encima de un círculo una de las dimensiones, se llegaba a las cuatro dimensiones relativista más el electromagnetismo. Ello ocurría debido a que se trataba de una teoría gauge U (1), en que U (1) corresponde al grupo de rotaciones alrededor de un círculo. Esto se puede considerar cuando se asume que el electrón tiene un grado de libertad que corresponde a un punto del círculo y que ese punto es libre de variar su posición en éste, de la misma forma como lo hacemos cuando nos movemos alrededor del espaciotiempo. Para el fotón, se da por entendido que lo contiene la teoría y que el electrón se mueve en función de las ecuaciones de Maxwell sobre el electromagnetismo.

El mecanismo de Kaluza-Klein da simplemente una explicación geométrica para este círculo, en que la quinta dimensión se da al enrizarse ese círculo hacia arriba. Hemos hecho una descripción bastante simplificada de lo que consiste la presencia de una quinta dimensión, pero para hacerlo así, hemos considerado también el diminuto tamaño del espacio en que se teoriza el mecanismo, pese a que reconocemos las profundas implicancias que tiene para la física.

El mecanismo de Kaluza-Klein da simplemente una explicación geométrica para este círculo, en que la quinta dimensión se da al enrizarse ese círculo hacia arriba. Hemos hecho una descripción bastante simplificada de lo que consiste la presencia de una quinta dimensión, pero para hacerlo así, hemos considerado también el diminuto tamaño del espacio en que se teoriza el mecanismo, pese a que reconocemos las profundas implicancias que tiene para la física.

¿Pero cómo podríamos saber si existen o hubo dimensiones adicionales? Por ahora, sólo podemos intuirlas y estimarlas a través de complejos estudios matemáticos y esperar si alguna vez se toma la decisión de construir un acelerador muchísimo más poderoso que los que hoy se encuentran en operaciones, e incluso de mayor capacidad que el SSC (Super-conducting Super Collider) que estaba destinado a encontrar casi todas las partículas que nunca hemos visto, pero su vida fue muy corta. Apenas se levantó un poco del suelo, el proyecto cayó estrepitosamente como consecuencia de un "no" del Congreso norteamericano. ¿Razón? Su inmenso coste, miles de millones de dólares, el equivalente a proveer alimentación básica a millones de desposeídos del mundo. Sin embargo, sabemos por la mecánica cuántica que si una dimensión espacial es periódica, el momento de esa dimensión se cuantiza, p = n/R (n = 0, 1, 2, 3…); mientras si la dimensión espacial desaparece, el momento puede adquirir una serie continua de valores. Por otra parte, al disminuir el radio de la dimensión compactada (el círculo se hace muy diminuto), el rango de valores permitidos del momento se hace muy amplio. Así, llegamos a una torre de Kaluza-Klein en cuanto a los estados del momento.

Si tomamos un círculo con el radio grande y dimensiones no compactificadas, los valores permitidos del momento se sitúan muy cerca unos de otros, llegando a formar una serie continua. Tanto las dimensiones mayores carentes de masa como, asimismo, las másicas pequeñas, se ubican espaciándose en la torre entre pequeñísimos trechos. Esto sería lo que ocasiona que, en la materia sometida para su estudio, en los actuales aceleradores en operaciones sólo se pueda llegar a observar en ella una composición de partículas. En consecuencia, se necesitarían aceleradores de la potencia o mayor que la del frustrado proyecto del SSC, no sólo para descubrir las extradimensiones, sino también algunas masivas partículas ligeras que predicen las teorías, pero que hasta ahora no se han encontrado.

Cuando estudiamos la teoría de Kaluza-Klein, hablamos de dimensiones que se representaban en la línea de un cilindro y, ahora, aquí se supone que vamos a analizar cuerdas con extradimensiones. Cuando Scherk y Schwarz teorizaron sobre la existencia de diminutas cuerdas en la naturaleza, hicieron un descubrimiento notable para el campo de la física teórica. En efecto, las cuerdas tienen una característica única cuando son compactificadas: se enrollan alrededor de una dimensión compacta enrollándose a lo largo de todo el espectro. Una cuerda cerrada se puede enrollar alrededor de periódicas dimensiones en distintas etapas de tiempo. Lo anterior implica, al igual que en la mecánica de Kaluza-Klein, la generación de un momento p = w R (w = 0, 1, 2…), pero con una diferencia sustancial, ya que éste sigue el camino inverso en relación a la dirección del radio de la dimensión compacta, R. De ese modo, la dimensión se compactifica llegando a ser pequeñísima en un cilindro de muy poca densidad.

Cuando estudiamos la teoría de Kaluza-Klein, hablamos de dimensiones que se representaban en la línea de un cilindro y, ahora, aquí se supone que vamos a analizar cuerdas con extradimensiones. Cuando Scherk y Schwarz teorizaron sobre la existencia de diminutas cuerdas en la naturaleza, hicieron un descubrimiento notable para el campo de la física teórica. En efecto, las cuerdas tienen una característica única cuando son compactificadas: se enrollan alrededor de una dimensión compacta enrollándose a lo largo de todo el espectro. Una cuerda cerrada se puede enrollar alrededor de periódicas dimensiones en distintas etapas de tiempo. Lo anterior implica, al igual que en la mecánica de Kaluza-Klein, la generación de un momento p = w R (w = 0, 1, 2…), pero con una diferencia sustancial, ya que éste sigue el camino inverso en relación a la dirección del radio de la dimensión compacta, R. De ese modo, la dimensión se compactifica llegando a ser pequeñísima en un cilindro de muy poca densidad.

Ahora bien, para poder insertar nuestro mundo tetradimensional en otro con seis dimensiones suplementarias, necesitamos conpactificar la teoría de las supercuerdas de diez dimensiones en múltiplos compacto de seis. Se puede pensar que ello se podría realizar con el mecanismo de Kaluza-Klein, como lo hemos descrito arriba, pero los resultados que se obtendrían son de una gran complejidad binaria.

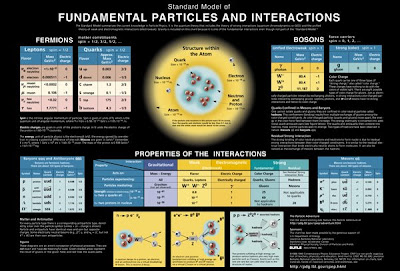

Una fórmula simple podría ser las de colocar las seis dimensiones suplementarias en una cantidad igual de círculos en una protuberancia sexadimensional, pero ello implicaría supersimetrías poco viables, pese a que se considera que éstas podrían existir en nuestro mundo tetradimensional en una escala de energía superior a un TeV. Este es un tema que ha centrado la investigación en los aceleradores de más alta energía del mundo. Por otra parte, la preservación de una cantidad mínima de supersimetría equivalente a N = 1 en cuatro dimensiones, requiere la compactificación de un múltiplo especial de seis, conocido como de Calabi-Yau.

Una fórmula simple podría ser las de colocar las seis dimensiones suplementarias en una cantidad igual de círculos en una protuberancia sexadimensional, pero ello implicaría supersimetrías poco viables, pese a que se considera que éstas podrían existir en nuestro mundo tetradimensional en una escala de energía superior a un TeV. Este es un tema que ha centrado la investigación en los aceleradores de más alta energía del mundo. Por otra parte, la preservación de una cantidad mínima de supersimetría equivalente a N = 1 en cuatro dimensiones, requiere la compactificación de un múltiplo especial de seis, conocido como de Calabi-Yau.

Las características del múltiplo de Calabi-Yau puede tener implicaciones importantes para la física de bajas energías, como en el caso de las distintas clases de partículas observadas en cuanto a sus respectivas masas, los cuantos y su origen. Sin embargo, se trata de un campo de investigación bastante complicado, ya que se da la existencia matemática de muchísimos múltiplos de Calabi-Yau y los físicos no han podido encontrar la fórmula para saber cuál de ellos utilizar en muchos de sus trabajos de investigación.

En ese sentido, al desarrollar los distintos conceptos que se implican en la teoría de las supercuerdas con diferente número de dimensiones suplementarias, se llega a concluir que la tetradimensionalidad está lejos de ser la única geometría de la naturaleza y que en ello la investigación física se encuentra incompleta, por lo menos en los niveles actuales de teorización. Por lo anterior, y al margen de la necesidad de unificar las cuatro fuerzas conocidas que dan la estructura a nuestro mundo, se ha embrionado la esperanza de que la teoría de las supercuerdas sin las perturbaciones estructurales que aún persisten en ella, nos pueda conducir a saber si nuestro universo siempre ha sido tetradimensional o que fluyó de una física con más de cuatro dimensiones que pudo haber existido durante la fase de alta energía del Big Bang, distinta a la física cuatridimensional de baja energía que hoy observamos. En una de esas, se halla un múltiplo de Calabi-Yau que abra el camino.

Un importante trabajo al respecto es el desarrollado por el físico-matemático Andrew Strominger, en el cual ha logrado demostrar que los múltiplos de Calabi-Yau se pueden conectar permanentemente uno con otro en transiciones cunifólicas y movernos en diferentes múltiplos en distintos parámetros de la teoría.

Un importante trabajo al respecto es el desarrollado por el físico-matemático Andrew Strominger, en el cual ha logrado demostrar que los múltiplos de Calabi-Yau se pueden conectar permanentemente uno con otro en transiciones cunifólicas y movernos en diferentes múltiplos en distintos parámetros de la teoría.

Esto sugiere que las distintas teorías tetradimensionales que generan los múltiplos de Calabi-Yau, pudiesen ser realmente fases de una única teoría subyacente.